Ubuntu 上 Spark 作业的性能瓶颈可能是由多种因素引起的。 以下是一些常见的性能瓶颈以及如何分析它们。

CPU性能瓶颈:

top或htop命令检查CPU使用情况并找到消耗最多 CPU 资源的进程。

分析您的 Spark 作业是否存在低效循环、递归或计算密集型操作。

考虑使用更高效的算法或数据结构来减少CPU的计算负载。

内存性能瓶颈:

使用free -m命令检查内存使用情况。泄漏或过度使用。

分析Spark作业的内存分配策略,包括spark.memory.fraction、Masu等参数是否设置合理。

考虑增加物理内存或使用具有更多内存的机器。

磁盘 I/O 性能瓶颈:使用

iostat 命令识别磁盘 I/O 性能显示 O 使用情况,查找 I/O 等待时间较长的进程。

分析您的Spark作业是否有频繁的磁盘读写操作,例如日志记录、数据持久化等。

考虑使用更快的磁盘(例如 SSD)或优化 I/O 操作策略(例如批量读取)。 并写)。

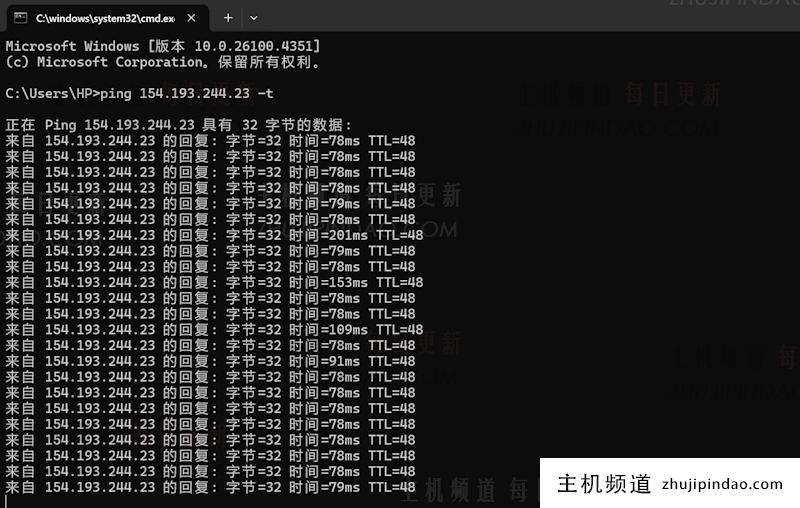

网络性能瓶颈:

运行iftop或nethogs命令。用于查看网络带宽使用情况并查看哪些进程消耗的网络资源最多。

分析您的Spark作业是否有重数据传输操作,例如shuffle操作。

考虑优化您的网络配置(例如增加带宽)、使用更高效的网络协议或使用分布式文件系统(如HDFS)来减少网络传输开销。

代码实现问题:

Spark作业没有低效的代码实现(例如使用不必要的函数调用)或分析。 循环等。

使用性能分析工具(JProfiler、YourKit 等)对代码进行性能分析,以查找性能瓶颈所在。

优化您的代码以减少不必要的计算和内存分配。

资源调度问题:

Spark 集群的资源分配,包括是否启用 Spark.executor.instances 分析。 。 适当设置 、spark.executor.memory 和其他参数。

考虑使用动态资源分配策略(如 Spark 的 spark.dynamicAllocation.enabled),根据作业需求自动调整资源分配。

监控集群运行状态,快速发现并解决资源争用问题。

要有效地分析和解决Ubuntu上的Spark作业性能瓶颈,可以使用一套全面的工具和技术来从多个角度评估作业性能并进行优化。

主机频道

主机频道

评论前必须登录!

注册