目录

在 Ubuntu 上管理 Spark 集群元数据时,您可以遵循多种最佳实践来确保集群的高效运行。 以下是一些重要提示。

使用Spark的远程元数据模式

配置Hive元数据:配置Hive的远程元数据数据模式这允许Spark访问存储在Hive 元存储。 这使得Spark可以使用Hive的元数据服务来查询和管理数据表。

Spark配置:您必须在Spark配置文件中指定Hive的远程元数据服务地址,以便您的Spark应用程序可以连接到Hive元存储。

优化Spark配置参数

内存分配:Spark内存资源根据集群内存大小,包括驱动内存进行合理分配。 和执行者内存。

执行器数量:根据正在处理的数据量和集群中的CPU核心数量调整执行器的数量,以充分利用集群的资源。

使用高效的数据存储格式

Parquet:Parquet提供高效的压缩和快速的数据访问能力,一种面向列的存储格式。提供

ORC:ORC(优化行列式)是另一种适合处理大型数据集的优化列式存储格式。

数据预处理

过滤:在将不需要的数据加载到Spark集群之前,通过过滤来减少数据量。 。

填充缺失值:适当填充缺失值,以避免处理过程中出现错误。

监控和调试 Spark 应用程序

使用 Spark UI:Spark UI 提供了一组丰富的监控和调试工具来帮助您监控 Spark 应用程序的执行状态和性能。

性能调优:通过监控 Spark 应用程序的性能指标,您可以发现并解决性能瓶颈。

使用Spark的缓存机制

缓存常用数据:使用Spark的缓存机制,将常用数据缓存在内存中,以提高数据处理能力。 速度。

上述技术可以让您在 Ubuntu 上有效管理 Spark 集群的元数据,并提高集群的处理能力和效率。

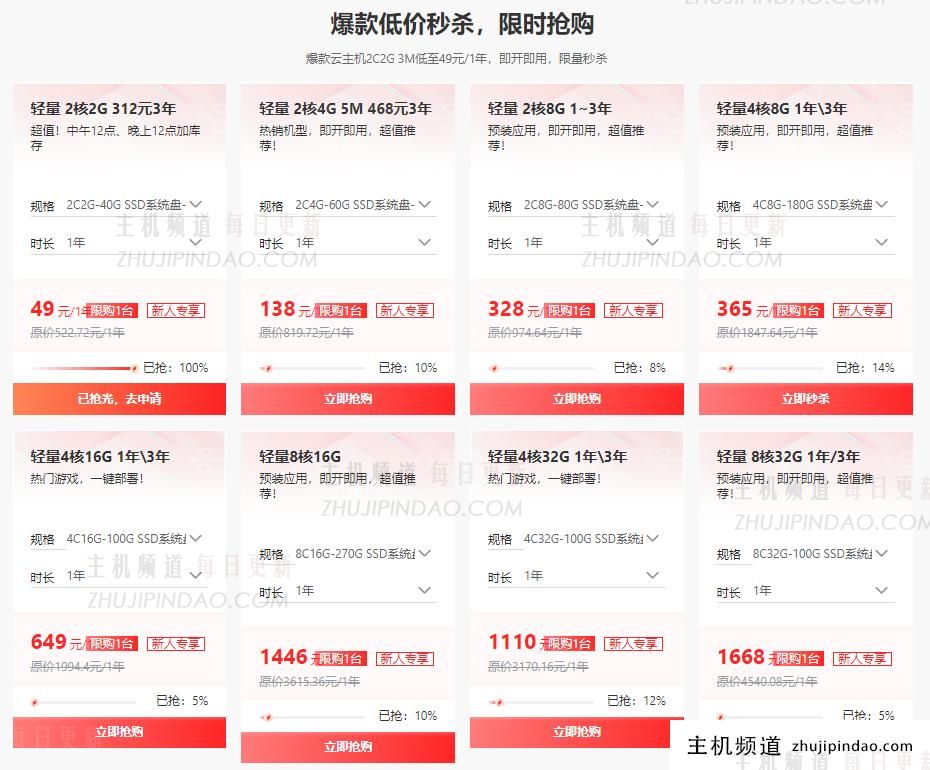

主机频道

主机频道

评论前必须登录!

注册