数据分区策略在 Ubuntu Spark 中对于优化性能并确保数据均匀分布非常重要。 推荐的数据分区策略是:

根据数据量分区:您可以根据数据大小创建不同数量的分区。 更大的数据集需要更多的分区来改善并行处理期间的负载平衡。 相反,数据集越小,使用的分区就越少。

基于数据特征分区:基于时间戳、地理位置或其他相关属性等数据特征进行分区。 这种分区策略允许 Spark 优化特定分区内的数据处理,从而实现更高效的查询。

基于键的分区:在处理键值对数据时,您可以根据键的分布执行分区。 这提供了数据的均匀分布并减少了分区之间的数据倾斜问题。 例如,如果某些键在数据集中出现的频率更高,您可以为这些键创建更多分区。

自定义分区函数:有时您需要根据特定的业务逻辑创建自定义分区函数。 例如,您可以根据数据的计算或业务规则来决定将数据分配到哪个分区。 这提供了更大的灵活性,但也需要更多的开发和维护工作。

在实现这些分区策略时,还应该考虑以下因素:

选择分区数量:Number 分区数量应该合理。 太多的分区会浪费资源并且管理起来很复杂。 另一方面,分区太少可能会导致集群资源利用不足。 因此,应根据数据大小、集群资源和处理需求来考虑分区数量。

处理数据倾斜:在某些情况下,数据可能在分区之间分布不均匀,从而产生处理瓶颈。 此时可以采用多种策略来解决数据倾斜,例如增加热分区副本的数量、使用加盐技术扰乱密钥等。

监控和调优:在实际应用中,您需要持续监控Spark作业的性能指标,并根据实际情况调整分区策略和其他配置参数。 这可确保作业高效运行并适当分配资源。

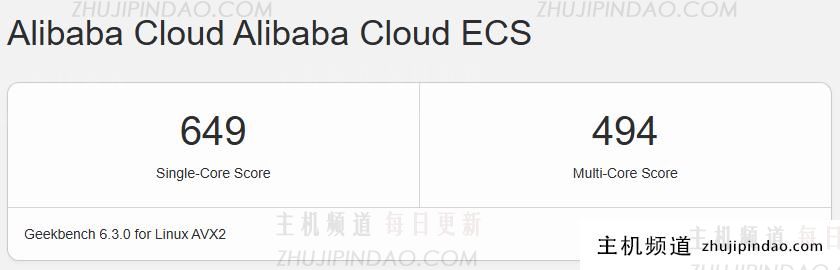

主机频道

主机频道

评论前必须登录!

注册