目录

最近AI这个词火得一塌糊涂,连带着“人工智能服务器”也成了大家热议的话题。很多人都在问,这玩意儿到底是啥?租一台得花多少钱?说实话,这价格范围可就大了去了,完全取决于你想要的配置。打个比方,像RAKsmart那边,一台入门级的GPU服务器(750 GPU, 32G内存, 1T SSD)月付大概是169.08美元,但这真的只是个起步价,配置往上加,预算也得跟着蹭蹭涨。

一、到底啥是人工智能服务器?

我知道文章开头提了一嘴,但可能还是有朋友感觉云里雾里的。别急,咱们今天就把这事儿给说明白了。

1、这玩意儿究竟是干嘛的?

简单来说,人工智能服务器就是一台专门为了跑AI计算任务而攒出来的“性能怪兽”。它的核心使命,就是高效地处理机器学习、深度学习这些极其消耗计算资源的工作。它跟普通服务器最大的不同,就是采用了所谓的“异构计算”架构,说白了就是把一堆不同功能的强大硬件(比如GPU、TPU这些加速卡)、高速网络和专门优化的存储系统给塞进一个机箱里,目的就是为了能进行海量并行计算和分布式训练。

2、它到底“怪兽”在哪?

(1)硬件配置

- 加速芯片:这可是灵魂所在。机子里塞满了像NVIDIA A100/H100这样的顶级GPU,或者谷歌的TPU等AI专用加速器。这些玩意儿的算力,是按“PetaFLOPS”(每秒千万亿次)来算的,简直恐怖。

- 高带宽内存:跑AI模型,特别是大模型,巨吃显存。所以这些服务器都配了HBM(高带宽内存)或者单卡就有48GB起步的超大显存,不然模型参数都装不下。

- 高速互联:一台服务器里那么多GPU,它们之间得能快速“交流”才行。所以像NVLink、InfiniBand这类技术是标配,保证了多卡协同工作时延迟极低。

- 存储优化:训练AI动不动就是TB级的海量数据,普通硬盘早趴窝了。所以NVMe SSD或者分布式存储系统是必须的,保证数据读写跟得上计算速度。

(2)软件生态

- 系统里通常都预装了优化过的AI框架,比如TensorFlow、PyTorch,还有CUDA这些并行计算库,让你上手就能用,省去大把配置时间。

- 而且,很多都支持容器化部署(比如用Kubernetes)和集群管理,让搞分布式训练这种复杂操作变得简单一些。

(3)所以,它能干啥?

- 训练和运行像ChatGPT这样的大语言模型(LLM)

- 搞计算机视觉,比如图像识别、视频分析

- 跑自动驾驶模型的仿真测试

- 用于科学计算,模拟分子运动、气候变化等等

二、租一台AI服务器要花多少钱?

了解完这东西有多牛,咱们就来聊点实际的——钱。自己买一台显然不现实,租用是目前最主流的玩法。我找了两家比较有代表性的服务商,大家可以参考下。

1、Megalayer GPU服务器租用价格

Megalayer这边提供了几种不同的GPU服务器方案,从入门级的GT740到性能更强的1050ti都有。我个人觉得,他们家的配置选择比较灵活,丰俭由人。如果你手头的任务对内存和硬盘速度有要求,那台64G内存配480G SSD的就挺不错。关键还是得看自己的预算和需求,别花冤枉钱。

| CPU | 内存 | 硬盘 | 显卡 | 价格/月 | 优惠链接 |

| E5-2660 | 16G | 1T HDD/240G SSD | GT740 (4GD5) | 1500元 | 点击查看 |

| 2*E5-2660 | 32G | 1T HDD/240G SSD | GT740 (4GD5) | 1750元 | 点击查看 |

| 2*E5-2660 | 64G | 480G SSD | 1050ti (4GD5) | 2350元 | 点击查看 |

2、RAKsmart GPU服务器租用价格

RAKsmart家的GPU服务器我一直觉得性价比挺高的。他们提供的E5-2620和E5-2680这些配置,性能都相当扎实。最让我心动的一点是“无限流量”,这对于需要长时间跑任务、数据吞吐量大的朋友来说简直是福音。而且还提供DDOS防护选项,对业务稳定性要求高的项目来说,是个很重要的加分项。

| 产品名 | GPU | 内存 | 硬盘 | 宽带 | 流量 | DDOS防御 | 价格/月 | 优惠链接 |

| E5-2620 | 750 | 32G | 1T SSD | 100M | 不限 | 可选 | $169.08 | 点击查看 |

| E5-2620*2 | 1050 | 32G | 1T SSD | 100M | 不限 | 可选 | $199.85 | 点击查看 |

| E5-2680*2 | 1080 | 32G | 1T SSD | 100M | 不限 | 可选 | $446 | 点击查看 |

主机频道

主机频道

香港VPS服务器为什么这么受欢迎?如何选择香港vps?

香港VPS服务器为什么这么受欢迎?如何选择香港vps? RAKsmart日本服务器怎么样?RAKsmart日本大带宽服务器租用 可选大陆优化线路月付$109 简单测评

RAKsmart日本服务器怎么样?RAKsmart日本大带宽服务器租用 可选大陆优化线路月付$109 简单测评 RAKsmart:新注册用户得$385大礼包!首单立享6.5折,还有VPS仅秒杀$1.99!

RAKsmart:新注册用户得$385大礼包!首单立享6.5折,还有VPS仅秒杀$1.99! 怎么租用美国多IP站群服务器?美国站群服务器哪家好

怎么租用美国多IP站群服务器?美国站群服务器哪家好 RAKsmart:海外站群服务器,美国/香港/新加坡/韩国/日本裸机云站群服务器低至$109/月 续费同价

RAKsmart:海外站群服务器,美国/香港/新加坡/韩国/日本裸机云站群服务器低至$109/月 续费同价 Jtti:夏季专用服务器促销-优惠价格低至每月96.9美元,终身循环折扣

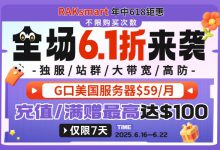

Jtti:夏季专用服务器促销-优惠价格低至每月96.9美元,终身循环折扣 RAKsmart 618狂欢7天,全场首月最低6.1折!支付订单满$50即得$10代金券!不限新老用户,抢购从速!

RAKsmart 618狂欢7天,全场首月最低6.1折!支付订单满$50即得$10代金券!不限新老用户,抢购从速!

评论前必须登录!

注册